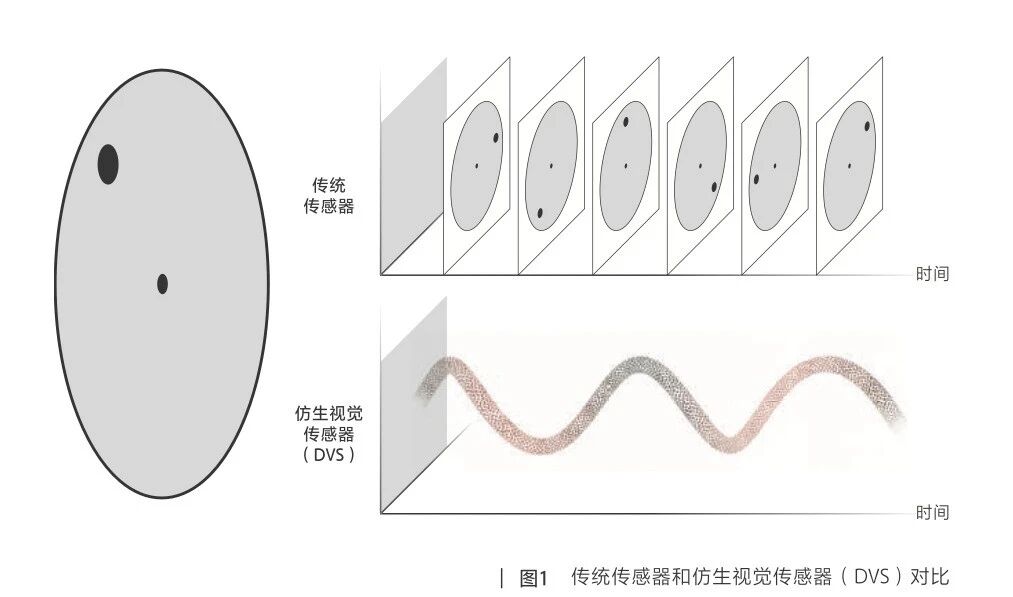

与传统的CCD和CMOS传感器不同,DVS没有“帧”的概念,而是以类似“流”的形式输出数据。

相较传统视觉传感器,动微视觉首款基于仿生视觉芯片研发的DVSLume相机具备显著的高速、高动态范围与低功耗优势,它标志着国产神经拟态视觉器件取得重大突破。

刘敏指出,视觉传感技术正在发生变化,不再只是简单地“拍照成像”,而是逐步升级为能够感知多种信息的系统。

刘敏

苏黎世联邦理工学院神经形态学博士、博士后,国家海外高层次人才、北京市特聘专家,动微视觉(北京)科技有限公司创始人

随着人工智能、机器人技术与物联网的深度融合,视觉传感技术已成为智能制造、自动驾驶和具身智能机器人等领域的核心驱动力。尽管传统视觉传感器在消费电子和工业自动化领域占据主导地位,但其帧式成像模式在高速动态场景下逐渐暴露出数据冗余高、功耗高等局限性,动态响应范围也难以满足复杂光照条件下的精准感知需求。

在此背景下,基于事件的仿生视觉传感器(Dynamic Vision Sensor,简称DVS)应运而生。DVS通过模拟人眼视网膜的神经拟态视觉特性,采取事件流形式输出数据,凭借自身微秒级延迟、低功耗和高动态范围等优势,成为行业技术迭代的重要方向。

在这场技术变革中,动微视觉(北京)科技有限公司(以下简称“动微视觉”)正快速崛起,成为备受瞩目的新锐力量。这家成立于2023年的硬科技企业,凭借创新的仿生视觉处理平台,已在工业自动化等多个领域实现技术落地,大幅提高了复杂场景下的视觉感知效率与决策精度。

动微视觉核心团队源自瑞士苏黎世联邦理工学院(ETH),创始人刘敏博士师从仿生类眼传感器的开创者托比·德尔布鲁克(Tobi Delbrück)教授。在接受专访时,刘敏深度剖析了仿生视觉行业的技术内核与未来图景。

视觉传感技术的三次跃迁

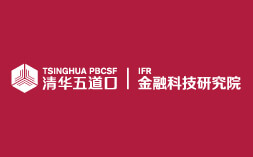

视觉传感技术经历了三次范式跃迁。从早期的CCD(电荷耦合器件)传感器开启数字成像道路,到20世纪90年代CMOS(互补金属氧化物半导体)传感器的广泛应用,直至当下仿生视觉传感器实现突破式创新,每一次标志性技术节点的突破都给行业带来了新的机遇与挑战。

首轮革命始于20世纪60年代。CCD传感器通过光电效应,首次实现了光信号到电信号的精准转换。凭借其高灵敏度和低噪声的特性,CCD传感器在70—80年代垄断了医疗影像、天文观测等领域。在这个时期,日本企业凭借其精密半导体工艺,在全球市场占据主导地位。

第二次革命则在20世纪90年代由CMOS(互补金属氧化物半导体)技术引爆。CMOS技术采用像素级集成放大电路的设计,大幅降低了传感器的成本与功耗。尽管在发展初期,CMOS在画质上不及成熟的CCD传感器,但其凭借良好的可量产性迅速主导了消费电子市场。此后,随着堆叠式工艺与背照式技术的突破,中美企业逐步打破日本企业的垄断,支撑起手机多摄、车载视觉等千亿美元级应用生态的繁荣。

当前,视觉传感领域正迎来由动态视觉传感器(DVS)引领的第三次革命。DVS仿生学设计突破了传统帧式成像的固有局限。基于神经拟态视觉系统构建的DVS,在140dB超宽动态范围与微秒级延迟等核心指标上实现了量级跃升,目前已成功应用于自动驾驶、工业缺陷检测等高实时性的场景(表1)。

值得关注的是,CMOS图像传感器与DVS的异构融合架构,标志着感知系统正朝“仿生+智能”的方向迭代升级。而动微视觉正处在这场变革的前沿。

开启仿生视觉产业化进程

DVS技术源自神经生物学。它最核心的突破是解决了传统视觉传感器难以兼顾低功耗和低延迟的难题。与传统的CCD和CMOS传感器不同,DVS没有“帧”的概念,而是以类似“流”的形式输出数据(图1)。

DVS是神经拟态(Neuromorphic Engineering)领域的重要成果。神经拟态最早由德尔布鲁克教授的导师卡弗·米德(Carver Mead)教授提出。他认为,可以模仿人脑的神经机制来设计更高效、更节能的计算系统。而DVS的产业化进程始于2006年,当时苏黎世联邦理工学院德尔布鲁克教授团队成功研发了DVS128芯片(128×128像素),首次实现异步事件驱动架构。相较于早期的“硅眼”方案,这款芯片舍弃了电阻网络设计,因而体积更小、噪声更低。同时,它采用地址事件表示(AER)协议高效传输数据,标志着仿生视觉技术走出实验室,走向工程化应用。当前,仿生视觉传感器除了DVS外,还包括ATIS(异步时间成像传感器)等产品。此外,DVS也借鉴了传统视觉传感器领域的堆叠架构等先进制造工艺,使其在性能上与传统CMOS传感器形成直接竞争。

动微视觉的崛起之路

动微视觉创始人刘敏的学术轨迹与DVS技术的演进脉络紧密交织。在苏黎世联邦理工学院攻读博士学位期间,刘敏师从德尔布鲁克教授,其研究聚焦于攻克DVS的核心痛点——光流算法及其硬件加速。这段关键经历为其日后创立动微视觉奠定了坚实基础。彼时,国内仿生视觉领域的研究仍处于起步阶段,刘敏敏锐地察觉到DVS技术的巨大潜力。他预见到,若将这项技术引入中国,必将催生众多关键应用场景。他开始着手推动DVS技术在国内的落地与商业化。2023年,刘敏携专利技术回国创立动微视觉。动微视觉的技术基石正是源自德尔布鲁克教授首创的DVS技术体系。放眼全球,目前仅有少数公司能够制造DVS芯片,除索尼、三星等大厂外,其余均源自德尔布鲁克技术谱系,形成“师承一脉”的产业格局。2024年,动微视觉发布了首款基于仿生视觉芯片研发的DVSLume系列超高速动态智能相机,标志着国产神经拟态视觉器件取得重大突破。相较于传统视觉传感器,DVSLume相机具备显著的高速、高动态范围与低功耗优势:其时间分辨率可达1μs(远超传统传感器的30ms),动态范围突破140dB(传统传感器仅为60dB),功耗则降至仅10mW(传统传感器通常超过100mW)。凭借对光线变化的极高敏感度,DvsCam堪称传统相机的“专业版”,能够在亚秒级瞬间精准捕捉物体的细微变化,即便在严苛的环境下也能长时间稳定作业。目前,该产品主要应用于工业、商业航天等领域,执行缺陷检测、事件监测、高速识别、智能定位等关键任务。纯DVS传感器虽具备微秒级响应优势,但受限于噪声与分辨率,难以满足复杂场景需求。2025年3月,动微视觉推出了第二款产品——融视DVSync系列相机。融视DVSync融合了仿生视觉相机(DVS)的超高速动态捕捉能力与传统RGB相机的高分辨率成像优势,提供了一种革命性的视觉解决方案。该相机通过双CMOS传感器协同工作(100万像素DVS+800万像素RGB),结合自研的时空同步融合算法,在保证高清画质的同时,实现了等效万帧级的捕捉性能,成功打破了“速度、分辨率、画质”的不可能三角。在刘敏看来,DVSync不仅是硬件的革新,更是机器视觉范式的变革。他预计,2025年,DVSync能够推动工业检测效率提高30%以上。

智能感知技术变革

刘敏指出,视觉传感技术正在发生变化,它不再只是简单地“拍照成像”,而是逐步升级为能够感知多种信息的系统。未来的关键在于将不同技术融合创新,并把感知和计算更紧密地结合在一起。这便是动微视觉下一步研究的核心方向——感算一体化技术。目前,行业内尚未推出感算一体产品,数据仍须传输至计算机或外部处理单元进行后端处理,这种感算分离架构在数据传输过程中会产生显著的系统功耗。当前,实现感算一体化面临两大关键技术挑战:一是计算架构重构问题,DVS的全新工作原理要求设计与之适配的新型计算架构;二是模数混合电路设计难题,感光部分的模拟电路与处理部分的数字电路如何在芯片面积受限的情况下高效集成,是亟待解决的硬件设计瓶颈。

技术融合:CMOS+DVS架构的协同创新

在视觉传感领域,CMOS传感器与DVS传感器呈现出显著的技术互补性,将二者融合可构建兼具高精度成像与低功耗特性的混合视觉系统。技术实现路径方面,堆叠式CMOS架构通过3D堆叠技术分离逻辑层与像素层,集成AI加速单元于传感器芯片内,可实现图像预处理及特征提取的本地化运算,有效降低数据传输能耗。此外,值得关注的还有异质集成技术。中科院微电子所研发的碳硅三维异质集成技术,突破了传统工艺热预算限制,有机融合硅基CMOS工艺与碳纳米管器件,提供了新的技术路径。应用场景拓展至自动驾驶领域时,该混合系统可并行处理高精度静态环境建模(依托CMOS的高分辨率特性)与动态障碍物实时追踪(基于DVS的微秒级响应速度),显著提高复杂路况下的决策效率。在工业检测场景中,DVS可精准捕捉高速运动中的瞬态缺陷事件,而CMOS则提供缺陷的亚微米级细节特征,形成“事件触发+高精成像”的协同检测机制,实现质检效率与精度的双重突破。

感算一体:从物理层到算法层的深度融合

在视觉传感领域,传统系统是将“感知”“传输”“计算”三个步骤分开,数据转换与传输的过程不仅有时间延迟,也会带来能效损耗。而“感算一体”架构,通过将计算单元与传感单元集成,让数据处理在光信号/电信号域的近数据端完成,减少冗余传输。产业应用中,感算一体芯片可显著降低系统端到端时延,使自动驾驶、机器人等的系统决策延迟缩短至毫秒级,在工业检测场景中实现缺陷特征的实时提取与分类,同时减少云端依赖以增强数据隐私保护。清华大学研发的OPCA全光感算芯片是典型创新成果,其开创性地实现“光入—光出”端到端计算范式,处理速度突破纳秒量级,可支撑每秒千亿像素级的实时数据处理。又如多模态光电忆阻器,集传感、存储与计算功能于一身,完成图像预处理、目标跟踪等任务时能耗可降低90%以上。这项技术目前还面临一些挑战,比如多模态数据接口标准化、算法和硬件如何协同优化等,需要进一步完善。尽管如此,新型智能感知技术在智能驾驶、工业物联网等领域已展现出巨大的应用潜力。这标志着,视觉感知系统正在从过去的被动式数据采集,转变为主动地、智能地去认知和理解周围的世界。一个更智能、更高效的感知时代正在到来。